DeepSeek R1 im Faktencheck - AI Hype aus China?!

DeepSeek R1 heisst der neue Hype in der AI-Welt und laesst die Werte der US-Techfirmen an den Boersen abstuerzen. Aber warum eigentlich? Ich erklaere euch in dieser Ausgabe was es damit auf sich hat, warum der Hype und diverse Statements einfach kompletter Quatsch sind, aber auch, warum es sich dabei um ein sensationelles Modell handelt!

Wenn ihr MeTacheles direkt unterstuetzen wollt, dann "chippt" doch einfach den Gegenwert einer Currywurst (gerne auch vegan) in meine Paypal-Kasse:

MeTacheles funktioniert nicht ohne euch und wenn ihr glaubt, dass dieses Format auch in eurem Netzwerk ankommt, dann teilt es doch genau mit diesem.

Ganz wichtig: Den woechentlichen Podcast gibt es auf diversen Plattformen wie u.a.

Apple - Spotify - Google - Amazon oder als RSS-Feed

Gerade Apple & Spotify-Abrufe helfen dem Format, denn dort gibt es entsprechende Rankings!

DeepSeek R1: Faktencheck zu Chinas AI-Hype

Manchmal fliegt einem ein Thema um die Ohren, das einfach nach einem Faktencheck schreit... und DeepSeek R1 ist genau so ein Fall. Innerhalb weniger Tage hat dieser AI-Hype aus China nicht nur Schlagzeilen gemacht, sondern die Boersenwerte grosser Tech-Firmen wie NVIDIA oder AMD kraeftig ins Wanken gebracht. Aber warum eigentlich? Was steckt wirklich hinter diesem Modell, und warum ist der Hype einerseits masslos uebertrieben, andererseits aber auch nicht ganz unberechtigt? Lasst uns das mal in Ruhe auseinandernehmen.

Der Hype um DeepSeek R1

DeepSeek R1, der neue Star aus der AI-Welt, wird als bahnbrechendes Modell gefeiert. Laut Berichten soll es aehnliche Leistungen wie GPT-Modelle erreichen, allerdings zu einem Bruchteil der Kosten. Da wird von "nur" 5 bis 6 Millionen Dollar Entwicklungsaufwand gesprochen – im Vergleich zu den hunderten Millionen, die OpenAI und Co. investieren. Klingt beeindruckend, oder? Aber bevor wir uns von solchen Zahlen blenden lassen... schaut mal!

DeepSeek wird von High-Flyer entwickelt, einem chinesischen Hedgefonds mit einem verwalteten Kapital von 7 Milliarden Dollar. Dieser Fonds hat sich einen Pool von Experten zusammengestellt, darunter Preistraeger:innen der Mathematik-, Physik- und Informatik-Olympiaden. Klingt elitaer? Ist es auch! Highflyer hat nicht nur das Know-how, sondern auch die Hardware: 50.000 NVIDIA H100 GPUs im Wert von rund 1,5 Milliarden Dollar wurden gekauft bzw. man soll darauf zugreifen koennen. Davon geht Scale AI CEO Alexandr Wang aus... Und genau hier wird es spannend.

Kosten und Realitaet

Die kolportierten 5 bis 6 Millionen Dollar beziehen sich lediglich auf die reinen Cloud-Kosten, wenn man das Modell in einer virtuellen Umgebung trainieren wuerde. Die Realitaet sieht anders aus: Allein die Hardware-Investitionen sprengen diesen Rahmen um ein Vielfaches. Hinzu kommen die Kosten fuer den laufenden Betrieb. DeepSeek R1 basiert auf 671 Milliarden Parametern und benoetigt allein 16 H100 mit jeweils 80 GB Speicher, um ueberhaupt einsatzbereit zu sein. Das bedeutet: Wer dieses Modell lokal nutzen moechte, muss erstmal eine halbe Million Dollar fuer die Hardware hinlegen.

Trotzdem: Die technische Leistung hinter DeepSeek R1 ist beeindruckend. Das Modell liefert Benchmarks, die in Bereichen wie Mathematik, Codierung und wissenschaftlichem Denken mit den besten US-Modellen mithalten koennen. Und es gibt einige innovative Features, die wirklich herausstechen.

Technische Highlights von DeepSeek R1

- Chain of Thought (Gedankenkette):

- Eine Technik des Prompt Engineerings, bei der das Modell angewiesen wird, seine Ueberlegungen Schritt fuer Schritt zu erklaeren.

- Fehler in der Argumentation koennen so leichter identifiziert und korrigiert werden.

- Dies fuehrt zu genaueren Antworten, da das Modell selbst reflektieren und Loesungen bewerten kann.

- Reinforcement Learning (RL):

- Anders als bei herkoemmlichen Trainingsansaetzen wird das Modell nicht direkt mit richtigen Antworten trainiert, sondern lernt durch eigene Erkundung.

- Vergleichbar mit der Lernweise eines Babys, das durch Versuch und Irrtum das Gehen lernt.

- Eine spezielle Methode namens "Group Relative Policy Optimization" wird genutzt, um Modellinstabilitaet zu minimieren und das Training effizienter zu gestalten.

- Model Distillation (Modell-Distillation):

- Da das urspruengliche Deep Seek-Modell mit 671 Milliarden Parametern extrem ressourcenintensiv ist, wird es verwendet, um kleinere Modelle (basierend auf Llama 3 oder Quen) zu trainieren.

- Diese kleineren Modelle erreichen aehnliche Leistungen wie das grosse Modell, benoetigen jedoch deutlich weniger Speicher und Rechenressourcen.

- In einigen Tests uebertrafen die kleineren distillierten Modelle sogar groessere Modelle wie GPT-4.0 oder Claude 3.5 in Mathematik-, Kodierungs- und Wissenschaftsaufgaben.

Der Haken an der Sache

Doch es gibt auch Schattenseiten. DeepSeek R1 wird hauptsaechlich ueber eine Webversion genutzt (fuehrt die App-Charts bei iOS und Co an!), und hier ist Vorsicht geboten. Nutzer:innen muessen nicht nur ihre Telefonnummer hinterlegen, sondern auch damit rechnen, dass ihre Eingaben genutzt werden, um das Modell weiter zu trainieren. Angesichts der Tatsache, dass die Server in China stehen, wirft das erhebliche Fragen zum Datenschutz und zur Datensicherheit auf.

Ein weiteres Problem: Der Hype um DeepSeek R1 fuehrt zu einer verzerrten Wahrnehmung. Es ist nicht das "Ende" fuer NVIDIA, OpenAI oder andere westliche Firmen, wie manche Schlagzeilen suggerieren. Vielmehr zeigt es, dass auch andere Laender innovative Ansatze verfolgen und damit Erfolge erzielen koennen. Das ist kein Grund zur Panik, sondern ein Weckruf.

Warum DeepSeek R1 wichtig ist

DeepSeek R1 demonstriert eindrucksvoll, wie man mit innovativen Techniken leistungsstarke Modelle effizienter und zugaenglicher machen kann. Besonders die Kombination aus Reinforcement Learning und Model Distillation ist ein spannender Ansatz, der das Potenzial hat, die KI-Entwicklung grundlegend zu veraendern. Und ja, auch die westlichen Firmen werden von diesen Ideen profitieren. Denn letztlich fliessen neue Erkenntnisse in die gesamte Branche ein.

Was bedeutet das fuer uns?

Stellt euch vor, wir haetten kuenftig KI-Modelle mit mehreren hundert Milliarden Parametern, die auf Smartphones oder kleinen Geraeten laufen koennen. Das ist keine Utopie mehr, sondern eine absehbare Realitaet. Und genau hier liegt die wahre Bedeutung von DeepSeek R1: Es oeffnet die Tueren fuer eine neue Generation von KI-Anwendungen, die leistungsstark, effizient und zugaenglich sind.

Fazit

DeepSeek R1 ist weder der "Heilsbringer" noch der "Boesewicht", als der es oft dargestellt wird. Es ist ein spannendes Modell mit innovativen Ansatzen, das die KI-Welt aufmischt und neue Moeglichkeiten aufzeigt. Doch der Hype ist masslos uebertrieben! Statt in Panik zu verfallen, sollten wir die Gelegenheit nutzen, von diesen Entwicklungen zu lernen und sie in unsere eigenen Projekte einfliessen zu lassen. Denn am Ende profitieren wir alle von einer diversifizierten und innovativen KI-Landschaft.

Ich bin gespannt, wie ihr das seht!

🗣️ Feedback geben

Ja, ihr koennt nun auch Teil vom MeTacheles Podcast und dem Newsletter werden. Wie? Einfach auf diesen Link https://t.ly/hallo klicken, kurze Sprachnachricht hinterlassen und dann geht es ab in die naechste Ausgabe!

Dir hat diese Ausgabe gefallen? Dann teile diese doch mit deinem Netzwerk. MeTacheles ist kostenlos, extrem zeitaufwendig & genau deshalb spiele ich jetzt auch ein wenig Staubsaugervertreter

Zum Podcast: Apple - Spotify - Amazon oder RSS-Feed

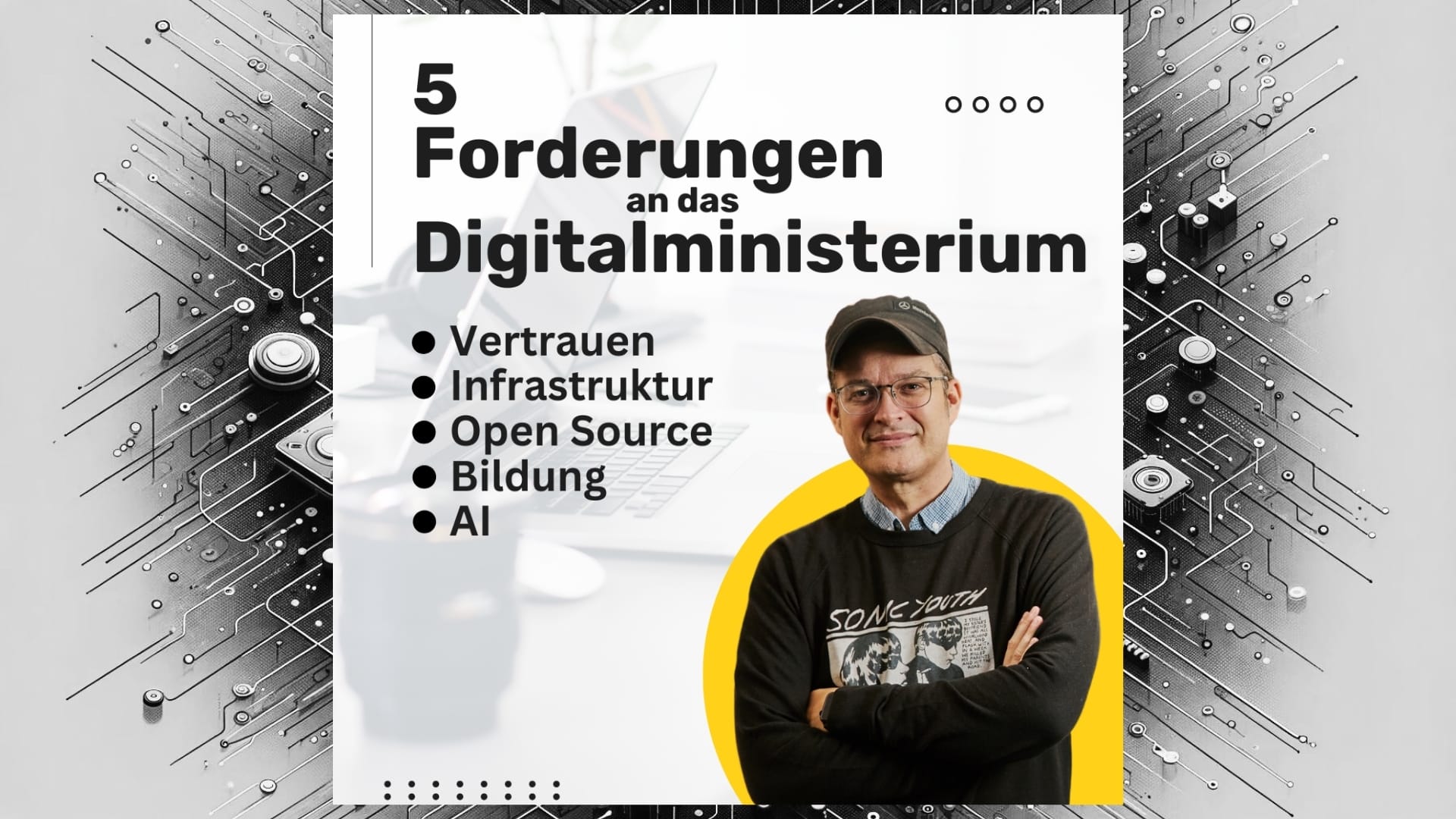

MeTacheles supporten & damit Baeume pflanzen

Ja, es gibt ein Abomodell fuer MeTacheles und ja, 30% der Umsaetze helfen dabei verschieden Baumpflanzprojekte zu unterstuetzen… und ab und zu haue ich noch “Spezial-Artikel” raus:

Bisher sind uebrigens 2 Ausgaben erschienen:

Wenn ihr meint, dass euch dies den Gegenwert eines Kaffees, Kaesekuchens oder ner Currywurst im Monat wert ist, dann koennt ihr entweder » HIER « oder auf den unteren Button klicken und aus den verschiedenen Abo-Modellen waehlen bzw. ihr koenntet ja auch ein Abo verschenken: